Introduction

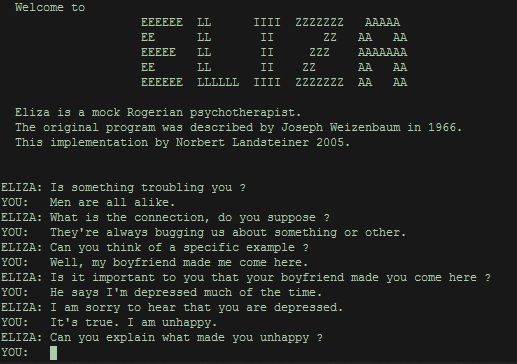

L’effet Eliza est un concept issu d’une expérience en intelligence artificielle datant des années 1960, conçu par le professeur Joseph Weizenbaum du MIT. Il a créé un programme informatique nommé ELIZA capable d’imiter une conversation en utilisant un traitement de texte très simple. Ce programme, souvent considéré comme l’un des premiers exemples de chatbot, utilisait des règles de transformation de texte pour répondre aux questions de manière qui semblait compréhensive, mais qui était en réalité superficielle.

Le concept de « l’effet Eliza » décrit la tendance des humains à attribuer des intentions, des sentiments et des pensées humaines à des conversations avec des machines, même lorsque les réponses sont générées par des scripts et des programmes informatiques. Cela repose sur la capacité humaine à chercher un sens même dans des réponses vides ou aléatoires.

Les robots conversationnels modernes, utilisant des modèles de langage avancés, reproduisent avec précision les « conventions sociales » telles que la politesse et peuvent exprimer une empathie qui semble réelle. Ce réalisme peut amener les utilisateurs à faire excessivement confiance à ces outils d’IA générative, à s’y attacher, ou même à les percevoir comme des humains. Cette relation peut pousser certaines personnes vulnérables à se tourner vers ces technologies pour un soutien psychosocial non prévu à cet effet, posant des risques pour la santé mentale (voir l’actualité du 29/03/2023).

Ainsi, nous pouvons dire qu’Eliza est en quelque sorte le premier chatbot qui a ouvert la voie à des développements plus sophistiqués dans les technologies de dialogue et d’interaction, tels que les assistants virtuels et les chatbots plus avancés comme GPT-4. Les systèmes d’IA modernes, comme les modèles de traitement du langage naturel, sont beaucoup plus complexes qu’ELIZA, utilisant des techniques telles que l’apprentissage profond pour générer des réponses pertinentes et contextuellement appropriées. Mais même si ces chatbots basés sur des LLM (Large Language Models) sont plus performants qu’Eliza, il n’en reste pas moins qu’ils ne comprennent rien à votre question ni à la réponse qu’ils vous feront. Ces modèles reposent sur l’affichage des mots les plus probables au regard de votre question. Ce sont en quelque sorte des modèles probabilistes sans aucune conscience ni dimension cognitive humaine.

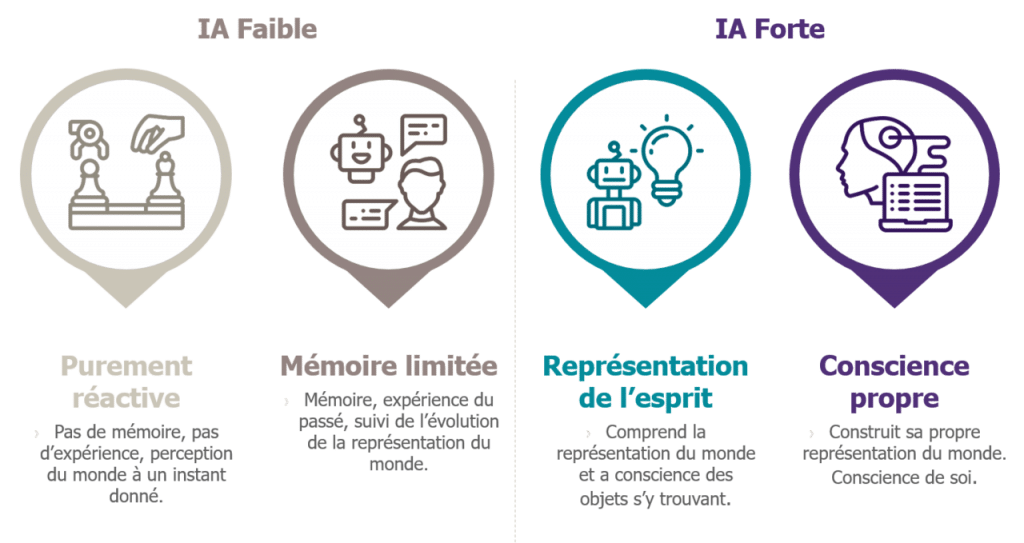

D’un point de vue technologique, cela nous montre qu’il y a une certaine confusion entre l’intelligence artificielle faible et l’intelligence artificielle forte. L’IA faible est conçue pour effectuer des tâches spécifiques et n’a pas de conscience ou de compréhension propre. ELIZA en est un exemple typique : le programme pouvait mimer une conversation sans aucune compréhension du contenu des échanges. L’IA faible est très répandue et inclut la plupart des applications d’IA que nous utilisons aujourd’hui, comme les assistants vocaux, les systèmes de recommandation, et les chatbots. L’IA forte, d’autre part, est théorique pour la plupart et se réfère à une intelligence artificielle qui posséderait une conscience, une compréhension et des capacités de raisonnement comparables à celles de l’humain. Une telle IA pourrait comprendre et interpréter le monde de manière autonome. On retrouve une illustration de l’IA forte dans le film de Stanley Kubrick, « 2001 : l’Odyssée de l’espace », avec l’ordinateur Hal 9000 doté d’une capacité de réflexion et d’émotions…

L’effet Eliza peut amener les gens à percevoir à tort des systèmes d’IA faible comme s’ils étaient dotés d’une intelligence de type IA forte. Les utilisateurs peuvent attribuer à ces systèmes des capacités de pensée, de compréhension, et même d’empathie, qu’ils n’ont pas en réalité.

Le programme Eliza appliqué à l’approche thérapeutique de Carl Rogers

Le programme ELIZA, développé par Joseph Weizenbaum, qui mimait un psychothérapeute, utilisait des techniques qui rappellent certaines méthodes de Rogers. Bien que simpliste, ELIZA était capable d’imiter une forme de conversation thérapeutique par des techniques de reformulations des affirmations par des questions. Par exemple, si un utilisateur disait « Je me sens triste », ELIZA pourrait répondre « Pourquoi dites-vous que vous vous sentez triste ? ».

Cette technique de miroir est une caractéristique de l’approche Rogerienne, qui vise à aider le patient à réfléchir à ses propres sentiments et pensées. cette méthode thérapeutique met l’accent sur l’importance de fournir un environnement de soutien, empathique et non-directif pour aider les patients à explorer et à résoudre leurs problèmes par eux-mêmes. Carl Rogers croyait profondément en l’importance de l’écoute active et de la réponse empathique pour favoriser le changement personnel.

L’effet Eliza, en tant que phénomène, met en lumière comment même une simulation d’une interaction thérapeutique peut amener les gens à percevoir une machine comme étant compréhensive et réfléchie, attribuant ainsi des qualités humaines et empathiques à la technologie.

Cependant, il est crucial de rappeler que ELIZA, ne comprend ni ne traite l’information de manière empathique; « elle » manipule simplement le langage de manière à simuler une conversation.

Eliza au cinéma avec le film « Her » et l’effet Pygmalion

Le mythe de Pygmalion, originaire de la mythologie grecque, raconte l’histoire d’un sculpteur qui tombe amoureux de sa propre statue, une création si parfaite à ses yeux qu’il souhaite qu’elle prenne vie. Sa dévotion est telle que la déesse Aphrodite exauce son vœu, animant la statue, qui devient une femme réelle nommée Galatée. Ce récit illustre l’idée de la création par un artiste devenant l’objet de son affection et de son désir.

Dans le film « Her » (2013) de Spike Jonze, cette dynamique est réinventée dans un contexte moderne et technologique. Theodore, un homme solitaire en pleine procédure de divorce, développe une relation avec Samantha, un système d’exploitation intelligent doté d’une capacité d’apprentissage et d’évolution. Contrairement à la statue de Pygmalion, Samantha n’a pas de corps physique; elle existe uniquement à travers une voix et une personnalité programmée, mais capable d’évoluer.

La relation entre Theodore et Samantha incarne une nouvelle forme du mythe de Pygmalion dans le sens où Theodore façonne indirectement l’évolution de Samantha par ses interactions et ses choix, notamment en sélectionnant le genre de la voix du système, qui influence leur dynamique relationnelle. Samantha, bien que dépourvue de corps, devient « réelle » dans le cœur et l’esprit de Theodore à travers ses réponses émotionnelles et son intelligence. Comme Pygmalion avec sa statue, Theodore devient captivé par sa création technologique.

L’extension du concept de Pygmalion à « Her » souligne non seulement la complexité des relations humain-machine dans un monde de plus en plus numérisé, mais aussi comment ces relations peuvent remodeler nos compréhensions de l’amour, de l’intimité et de l’identité. Le fait que Samantha possède une voix qui affecte Theodore rappelle la transformation de la statue en humaine dans le mythe original, symbolisant une forme de vie et d’identité.

Ainsi, le film explore les frontières entre le réel et l’artificiel, questionnant les limites de l’amour et de la relation.

Conclusion

L’effet Eliza reste pertinent aujourd’hui car il souligne l’importance de la perception utilisateur dans l’interaction avec l’IA. La façon dont les utilisateurs perçoivent et interagissent avec ces systèmes est fortement influencée par des réponses qui semblent intuitives ou empathiques, renforçant l’illusion d’une compréhension et d’une interaction réelles, même si, à ce jour, l’IA n’a pas de conscience réelle ou d’intention propre.